Статья посвящена SEO аудиту сайтов, который позволит выявить явные и неявные ошибки оптимизации, индексации и общей работы сайта. Бывают случаи, когда ломаешь голову над причиной того, почему же продвижение сайта не является успешным, но, как только ошибка находится — всё становится на свои места. Проведя аудит сайта и оценив все пункты его оптимизации, можно найти слабые места сайта и «подкрутить» их. Рассмотрим всё по порядку.

План статьи:

- §1. Проверка на присутствие в ПС.

- §2. Проверка индексации страниц.

- §3. Проверка на запрещённые методы продвижения.

- §4. Оценка оригинальности контента.

- §5. Проверка на ошибки в HTML коде.

- §6. Анализ работы хостера.

- §7. Проверка внутренней оптимизации.

- §8. Оценка сайта глазами ПС.

- §9. Проверка региональной зависимости.

§1. Проверка на присутствие в ПС

Первым делом проверим сайт на присутствие в поисковых системах. Получить результат можно, посмотрев, есть ли страницы сайта в индексе (вместо «seoded.ru» вписываем свой домен):

- Яндекс — https://yandex.ru/yandsearch?text=seoded.ru

- Гугл — https://www.google.ru/search?q=site:www.seoded.ru

Если присутствует 1 и более страниц — сайт находится в ПС, то есть индексация есть. Если её нет, то добавляем:

- Яндекс — https://webmaster.yandex.ru/sites/add/

- Гугл — https://www.google.com/webmasters/tools/home (кнопка «Добавить ресурс»)

В тех случаях, когда добавление в ПС запрещено — скорее всего, домен забанен. Об этом читайте в другой статье.

§2. Проверка индексации страниц

Проверив на присутствие в ПС, оцениваем количество страниц, участвующих в поиске. Если сайт относительно новый, то всех страниц в индексе можно и не ожидать. Однако, если сайту несколько месяцев и количество меньше того, которым обладает сайт, то возможен ряд причин:

- Сайт находится под фильтром АГС

ПС – Яндекс, кол-во страниц в индекс гораздо меньше “локального» количества, по сравнению с Гуглом. - Неучтённые страницы запрещены к индексации

либо через robots.txt, либо через метатеги запрета — <META CONTENT="NOINDEX,NOFOLLOW"> - Ошибки HTML кода

Отсутствие декларации <!DOCTYPE>, невалидная кодировка - Другие внутренние и внешние факторы

Дублированный контент, большое кол-во ВС, неподдерживаемый формат документа и т. д.

Советую добавить сайт в панель вебмастера Яндекса и проследить, какие страницы не были допущены к индексации и почему. Посмотреть можно в графе «Исключено роботом».

Ещё статья на эту тему — Как добавить сайт в индекс поисковых систем?

§3. Проверка на запрещённые методы продвижения

Страдать сайт может и от запрещённых методов продвижения, которые могли быть применены и без вашего участия. Распространены:

- Нечитаемый пользователем или скрытый текст

Совпадение цвета текста и фона. Очень грубый и чёрный способ обмана ПС. Наказывается на раз. Проверить можно визуально, нажав «CTRL+A». Если выделится текст, которого не видно, то его цвет совпадает с цветом фона. - Клоакинг (от англ. cloaking — маскировка, укрытие)

Различие информации, которая выдаётся пользователю и ПС. То есть ПС видит одну страницу (напичканную ключами), а пользователь — другую (хорошо оптимизированную и читаемую). Технически реализуется весьма непросто. Поэтому проверяем, чтобы основные страницы содержали тот же текст, что видит ПС. Проверяйте соответствие КЭШа страницы в поисковой системе к текущему состоянию (в результатах поиска нажмите «Сохранённая копия»). - Дорвеи

Это страницы сайта, которые оптимизированы под конкретные запросы путём повышения плотности ключевых слов к общему тексту. Призваны для привлечения трафика с ПС. Проверяйте, не являются ли страницы вашего сайта дорвеями и не ссылаются ли они на ваш сайт (полуюмор). - Свопинг

Данный чёрный метод заключается в том, что после достижения акцептором (продвигаемой страницы/сайта — прим. Сеодед.ру) верхних позиций по конкурентным запросам и привлечения трафика, он резко меняет содержание той же страницы, что приводит к косому взгляду со стороны ПС. Проверяйте соответствие КЭШа к текущему состоянию. - Ссылочный спам

Обмен ссылками также карается ПС. Размещая ответную ссылку на страницах сайта, вы повышаете количество ВС (внешних ссылок). Тем самым даёте повод ПС считать ваш сайт линкопомойкой. Проверить внешние ссылки можно сервисами и программами с этой страницы. - Избыточное автоматическое перенаправление (редиректы)

Страницы сайта используют редирект кодами — 301, 302, 303. Стоит использовать только в случае переноса страниц на другие адреса.

§4. Оценка оригинальности контента

Неоригинальный контент является весомым вкладом в применение санкций от ПС. Выражается:

- Фильтр АГС 30 (ex 17)

Дублированные страницы одного домена просто исключаются из индекса, так же, как и ненужные (по мнению Яндекса). Пример: архивы сайта, теги, рубрики, результаты поиска, версии для печати. Все эти страницы содержат в себе контент, который повторяется относительно прямого адреса страницы. Избежать фильтра можно закрыв страницы метатегом <META NAME="ROBOTS" CONTENT="NOINDEX">, либо указав запрет в файле robots.txt. - Понижение в ранжировании

То есть ПС не дают высоко ранжироваться сайту с неуникальным контентом. Высоких позиций можно не ждать.

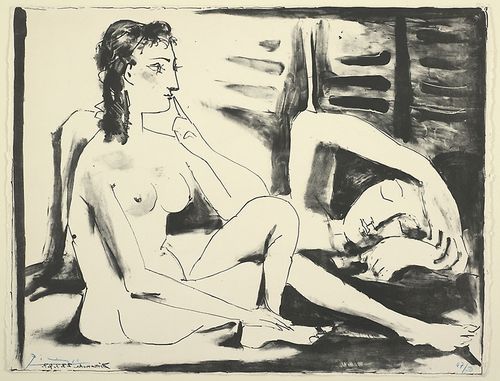

Сегодня проверить контент на уникальность можно множеством программ и сервисов. Из программ наиболее распространена Advego Plagiatus (скачать можно с сайта). Вбив адрес сайта или вставив текст вручную, получаем результат:

В случае такого результата, если чувствуете, что позиции сайта не высокие — меняйте текст на уникальный.

§5. Проверка на ошибки в HTML-коде

Ошибки в коде сайта также могут непосредственно влиять на проблемы с индексацией, позициями, продвижением. Самый простой способ проверить сайт на валидность кода — сервис W3C Validator. Основные грубые ошибки в коде HTML:

- Отсутствие декларации <!DOCTYPE>

Декларация, отвечающая за объявление типа документа. То есть она сообщает, какую версию (X)HTML вы используете. Её отсутствие, в ряде случаев, пагубно влияет на корректность документа, что приводит к проблемам взаимоотношений с ПС. - Errors, Warnings

Несущественные ошибки, которые следует разбирать с помощью W3C Validator (ссылка выше). Советую приводить код к валидному виду. - Кодировка

Проверяйте сайт на соответствие кодировки самого кода и указанной кодировки в метатеге <meta http-equiv="Content-Type" content="text/html; charset=кодировка">.

Несоответствующие кодировки напоминают клоакинг. - Незакрытый NOINDEX

Бывают случаи, когда с помощью тега NOINDEX запрещают индексацию какой-либо внешней ссылки или куска текста и просто забывают его закрыть. То есть вместо правильного варианта, вида

<noindex>текст или ссылка, которые закрываем от индексации</noindex>,

ставят

<noindex>текст или ссылка, которые закрываем от индексации.

В этом случае, всё, что идёт после открывающего тега <NOINDEX> в индекс Яндекса не попадёт. Следует тщательно проверять тег <NOINDEX> на закрытие!

Также следите и за другими тегами. Ошибки с их закрытием, может, и не так фатальны, но проблем могут доставить много.

§6. Анализ работы хостера

Здесь самое важное — проверка скорости загрузки сайта. Низкая скорость отдачи информации от серверов вашего хостера может привести к тому, что ПС будут пренебрежительно относиться к ранжированию и индексации вашего сайта. Задав вопрос «Зачем ПС выводить на высокие позиции сайт, который грузится очень долго?», можно самому додумать ответ. Проверить скорость загрузки сайта и, следовательно, скорость работы сервера можно через онлайн-сервисы. Вписывайте ваш сайт + сайты ваших конкурентов и сравнивайте результаты. Более 3 секунд — следует срочно переезжать!

Также советую отследить перебои в работе серверов хостера. Это можно сделать, просмотрев логи ошибок (читать FAQ хостера). Естественно, если сайт несколько раз в день просто выключается из-за того, что на сервере большая нагрузка, то следует сменить хостера. А если сбой произойдёт в момент или в преддверии апдейта выдачи? Многие испытывают проблемы, поэтому анализу хостинга тоже следует уделить время.

Мониторить сайты на доступность лучше всего с помощью сервиса Ping-Admin. Там всё просто и удобно.

Принцип работы сервиса таков, что из разных точек мира (на сегодня их больше 100 штук) производится периодическая проверка доступности сайта. В результате при «падении» хостинга у вас будет информация как на ящике, так и в виде СМС. Это позволяет просто с феерической скоростью набрать номер хостинг-провайдера и решить проблему оперативно.

Есть проблемы, правда. Но они нивелируются плюсами такого подхода. Допустим, если «ляжет» канал вне России, зарубежка — сервис, естественно, будет сигнализировать о недоступности, но в РФ сайт работать будет. Также есть постоянные отчёты и «кнопка» с циферкой суммарной (сколько в % времени был доступен сайт).

Так что реально рекомендую потратиться на 5$ и брать тариф на несколько сайтов. Хотя там и фри-версия, вроде бы, есть.

§7. Проверка внутренней оптимизации

В зависимости от качества, внутренняя оптимизация может способствовать как повышению позиций сайта и индексации, так и понижению в ранжировании. Рассмотрим основные моменты:

- Более 1 тега H1

Тег H1 подразумевает одно вхождение в документ, так как это заголовок верхнего уровня. Сравнить можно с заголовком книги, который, по стандарту, встречается 1 раз. Повторное вхождение может привести к тому, что ПС будут с опаской смотреть за страничкой.

Пользуемся сервисом проверки контента. - Количество ВС

Внешние ссылки — один из тех параметров, к которым конкретно Яндекс относится весьма негативно. Ссылаясь на другие сайты, вы, как минимум, передаёте им свой вес, а также — позволяете поисковому роботу переходить по таким ссылкам. Особенно плохо будет если ссылки ведут на некачественные сайты, к которым, скорее всего, ПС уже применили санкции. За это наказывается и сам акцептор. Советую скрывать такие ссылки тегом <noindex>ВС</noindex>. Количество не скрытых ВС — не больше 5-6, особенно с морды.

Для просмотра и оценки внешних ссылок пользуемся сервисом анализа сайта. - Количество реальных ВС

Все открытые + скрытые от поисковых систем внешние ссылки будем называть «реальные ВС». Яндекс не обходит внешние ссылки, заключённые в noindex. Он их прекрасно видит и хранит у себя в базе, вот только не придаёт им значения. Количество реальных ВС советую делать не более 15. - Чрезмерность тегов выделения

Всякие теги выделения (b, strong, u и т. д.) должны знать свою меру. Если на странице несколько вхождений ключевого запроса в текст, то выделение более 1 раза не имеет смысла. Повторное выделение приводит, во многих случаях, к санкциям и понижению в ранжировании.

Пользуемся сервисами для анализа контента. - Плотность ключевых слов

Плотность ключевых слов — отношение количества ключей ко всему контенту страницы. На то она и плотность, что должна быть в меру. Превышение плотности — полудорвей. Оптимальной плотностью считаю до 10%.

Пользуемся сервисами для анализа контента. - Количество символов текста

Текст на странице — неотъемлемая её часть. Даже основная. Так как посетитель сайта, перейдя с ПС, хочет видеть информацию, релевантную своему введённому запросу, то не стоит его разочаровывать. 1-2 предложения никому не интересны, да и высоко ранжироваться такие страницы вряд ли будут. Тем более, если страница содержит текст в сайдбаре, футере и шапке сайта, то он будет повторяться на всех страницах. И основной текст, если он состоит из малого количества символов, не поможет вам избежать фильтра АГС-30. В большинстве случаев, такой статичный текст составляет порядка 1000 символов. Советую для остального составляющего страницы (основной текст) использовать: от 4000 символов для морды и от 2000 для внутряка.

Пользуемся сервисами для проверки количества символов. - Дублирующие ссылки

На странице могут присутствовать внутренние ссылки на ту же страницу с разными анкорами. По сторонним экспериментам было замечено, что Гугл учитывает только первую ссылку, Яндекс — все. Можно, конечно, и воспринимать как факт, но превышать количество в 2 ссылки нет смысла.

§8. Оценка сайта глазами ПС

- Robots.txt

Этому пункту следует уделить больше внимания. Так как robots.txt — инструкция для роботов поисковых систем, следуя которой они принимают решения об индексации. Самая распространённая ошибка — указание директивы Disallow в таком виде:

Disallow: /

То есть таким образом мы запрещаем весь сайт к индексации!

Хорошим robots.txt считаю:

User-agent: Yandex

Disallow: /категория не для индекса

Disallow: /категория не для индекса

Host: www.seoded.ru

User-agent: *

Disallow: /категория не для индекса

Disallow: /категория не для индекса

Sitemap: https://www.seoded.ru/sitemap.xml

Где:

User-agent: Yandex — указание нижестоящих правил для Яндекса;

Disallow: /категория не для индекса — категория или страница, которая нам не нужны в индексе;

Host: www.seoded.ru — указание на основной домен (с www или без). Данная директива указывается непосредственно к поисковой машине Яндекс;

User-agent: * — указание нижестоящих правил для всех ПС;

Sitemap: https://www.seoded.ru/sitemap.xml — указание ссылки на карту сайта в формате xml;

Перед вторым указанием инструкций для ПС следует ставить пустую строку, так же как и перед картой сайта!

Более подробный разбор файла инструкций для поисковых систем robots.txt мы будем рассматривать в другой статье. - Текст и ссылки

Проверяйте, какой текст и ссылки видят поисковые роботы. Проверить можно одним из сервисов для анализа сайтов.

§9. Проверка региональной зависимости

Продвигая сайт, нужно обязательно следить за региональной привязкой к самому сайту и к геозависимостью ключевых запросов. Запросы делятся на:

- Геозависимые запросы

Те, при которых сайты ранжируются в разных регионах по-разному. - Геонезависимые запросы

В любом регионе ранжирование сайтов происходит одинаково.

Проверить на зависимость можно через поиск в разных регионах или с помощью всё тех же сервисов для seo-анализа.

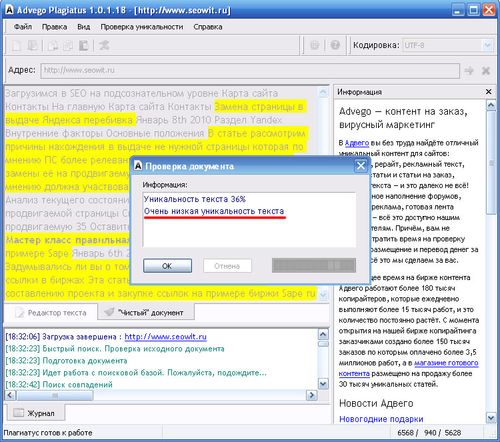

Пример геонезависимого запроса — запрос «SEO» (по ссылке, картинка откроется в полном размере):

Выдача одинаковая — запрос геоНЕзависим.

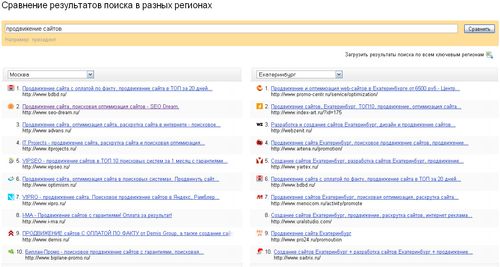

Пример геозависимого запроса — запрос «продвижение сайтов» (для увеличения картинки, кликните):

Выдача разная — запрос геозависим.

Если вы продвигаете сайт по геозависимым запросам, то присвоение региональной зависимости сайту — крайне обязательно! В остальных случаях — не обязательно.

Подробнее про геозависимость запросов и региональную принадлежность сайта читайте в других статьях.

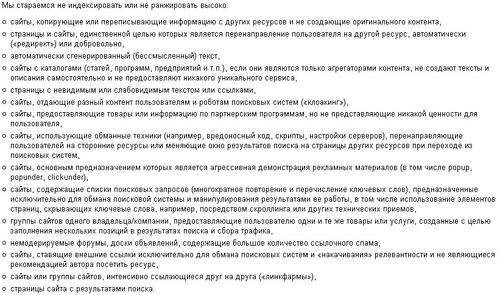

И напоследок — вырезка из правил Яндекса, который высоко не ранжирует сайты, если (для увеличения картинки, кликните):

Автор: Алексей Скорняков.

Ещё материалы по этой теме:

- Запросы-пустышки

- Мифы и правда про ИКС Яндекса

- Ссылочные пирамиды (пирамиды ссылок)

- Inserp — система SEO аналитики, анализ запросов и сайтов

- Как правильно копипастить статьи?

Комментарии:

ZxKill

12.01.2010

Спасибо! очередная отличная статья, разжеванная для «чайников»

пойду потестирую свои сайты

seo2z

12.01.2010

В комментариях можно делиться своими косяками, которые в любом случае есть у каждого! =)

satoved

12.01.2010

Хорошо написана, но не хватает примера сео-аудита определенного сайта.

seo2z

12.01.2010

Тогда напишу вторую часть с примером, по подробнее

ZxKill

12.01.2010

у меня кстати на сайте, на главной страничке (там как и у всех анонсы новостей) все заголовки этих самых новостей в тэге h1, так шаблоном задумано, это получается сильно плохо?

ZxKill

12.01.2010

и еще вопрос в догонку:) если на странице например 2 одинаковые ВС, как к этому относятся ПС, клеят их в одну или считают за 2 ВС ?:)

seo2z

12.01.2010

>>это получается сильно плохо?

плохо, но не смертельно. Но стоит опасаться санкций

>>как к этому относятся ПС, клеят их в одну или считают за 2 ВС ?:)

Яндекс точно считает за 2

sup3rstar

12.01.2010

А в robots.txt для яшибота, путь к карте сайта прописывать не обязательно? или не нужно?

Tod

12.01.2010

Я как раз занимаю поиском идеала в роботс.тхт — с твоим согласен на 100% только есть 1 вопрос — Sitemap для Яши указывать не нужно? или оно автоматом считывает его с правил «для всех» роботов?

SeoTochka

12.01.2010

Хороший мануал для анализа.

sup3rstar

12.01.2010

Tod, по идее Яша не должен лезть «для всех», если для него отдельно прописаны инструкции.

seo2z

12.01.2010

>>А в robots.txt для яшибота, путь к карте сайта прописывать не обязательно?

Путь прописывается для всех ботов после указаний к опредеённым, разделитель — пустая строка

SeoTochka

12.01.2010

Про «Проверка региональной зависимости» четко разложил.

sup3rstar

12.01.2010

А как можно повысить позиции в выдаче в регионе, который не основной для сайта?

seo2z

12.01.2010

>>А как можно повысить позиции в выдаче в регионе, который не основной для сайта?

Если запрос гео-зависим, то очень сложно. Только большим бюджетом. Если нет, то регион не имеет значение. Проверяйте запросы на гео-зависимость!

Юрий

12.01.2010

Ну вот описано отлично, правда есть проблемка, мне всё это не помогает, а почему? выходитчто страница попадает в индекс, и через деньвыпадает, и так все статьи…

в одном из каталогов при добавлении обратной ссылки мне показало что стоит ноиндекс на страницу, проверив — всё норм, нет ничего, …можно совет? что делать?

seo2z

13.01.2010

Немного не понятно, в чём конкретно проблема и что за каталог. Распишите, попробую помочь

MyOST

13.01.2010

«Анализ работы хостера»

Здесь пожалуй стоит упомянуть сервис *** для профилактики, не только скорость, но и доступность.

seo2z

13.01.2010

MyOST +1

Распишите принцип сервиса и работы с ним (в 1-2 абзаца)? Включим в статью + постовой на вас

MyOST

13.01.2010

Принцип работы сервиса таков, что из разных точек мира … (читать в статье, о проверке хостера)

seo2z

13.01.2010

2 MyOST:

Обновил статью, добавил описание, чуть подкорректировав. Ссылку на твой блог сделал активной, + внёс в white список (ссылка в комментах без noindex)

Zerohold

13.01.2010

Ссылка для дополнительных регистраций сайта (Дополнение к разделу «Проверка на присутствие в ПС»)

*** — регистрация в ПС Yahoo

*** — регистрация в ПС Апорт

*** — регистрация в ПС Bing (бывший MSN)

*** — регистрация в ПС GoGo

*** — регистрация в ПС Nigma

Все эти регистрации бесплатны, и есть пить не просят, но позволяет ваш сайт махом закинуть в ПС.

К сожалению с проверкой регистрации в указанных выше каталогах не разобрался пока, поэтому проверяю пока только вводом своего сайта и проверяю по наличию результатов в поиске.

Буду рад если будет расписан какой то способ по определению сайта в данных ПС

Ходзинский Александр

13.01.2010

Есть вопрос по поводу свопинга. Может ли теоретически быть забанен сайт, если поменялся контент сайта, либо была дооптимизация страничек?

Дима

13.01.2010

Про роботс хорошо написано, все правильно, я тоже придерживаюсь такого же мнения.

seo2z

13.01.2010

>>Буду рад если будет расписан какой то способ по определению сайта в данных ПС

Быть может и рассмотрим, если будет актуально

>>Может ли теоретически быть забанен сайт, если поменялся контент сайта, либо была дооптимизация страничек?

Теоретически да

Сергей

13.01.2010

Пробежался быстро по статье, т.к. в общем это знал. Единственное с чем маленько несогласен, это с валидацией. бОльшая часть сайтов нарушает валидацию, обычно верстают таблично, присваивают стили яйчейкам таблиц и т.д. Однако существует гипотиза, что сайты 100% проходящие валидацию имеют бОльший вес в глаза ПС — по моим данным (а у меня где то ~3,4 сайта полностью валидные т.к. верстались слоями а не таблицами) некоторые плюсы, и в некоторых ПС действительно наблюдаются. Будет интересна статья про регистрацию в каталогах так же, однако геозависимость меня волнует больше

Seo

13.01.2010

Пока до конца дочитал…начало забыл, надо было статью чуток разбить, а так как всегда спасибо.

akiselev

13.01.2010

Выдача одинаковая – запрос гео-зависим — здесь все-таки наверно имелось ввиду, что выдача разная?)

seo2z

13.01.2010

да, конечно разная. Поправил, спасибо!

Строитель

13.01.2010

Вот у меня вопрос — имеет ли смысл создавать сателлитов(или дорвеев) под гео-зависимый запрос? То есть для каждого неконкурентного города свой сайт, который ссылается на основной ресурс. Не баниться ли такое дело Яндексом?

seo2z

13.01.2010

Хороший сателлит не банится, если делать правильно. Но стоит ли заморачиваться под каждый запрос? Легче выбрать региональных доноров в сапе

stArik

17.01.2010

Ну ничего себе размеры статьи Неосилил

Александр

18.01.2010

Забыли проверку на наличие полных и неполных зеркал. Оч. часто встречаю клиентов, у которых по два, а то и три сайта. Проверять удобно поиском по номеру телефона или адресу

Ван ька

23.01.2010

Хорошая статья, респект автору.

У меня на одном сайте, запрещенные страницы (запрещены с момента их создания), несмотря на , в индексе, в то время как около 900 нормальных страниц контента, правда, коротких (термины словаря — уник и рерайт) — не в индексе…

Сайтовик

24.01.2010

Спасибо за статью — очень полезно. Но по наблюдениям, как раз снизилось влияние объёма статей. 2000 символов совсем необязательно.

seo2z

Январь 24th, 2010

А я считаю, весьма обязательно. Потому что это исключает доноров, страницы которых не пригодны для продвижения. Количество символов текста на странице включает себя тексты меню, футера и так далее… Что составляет порядка 1000 знаков, остальные 1000 знаков считаю самым минимумом для контента…

Ivan

27.01.2010

Спасибо Большое за Пост…всегда было интересно узнать как проверить страницу на наличие ошибок!

пользователь

31.01.2010

Полезная статья. По поводу скрытых текстов и т. п. интересно, стоит ли относить к такому тексту (ссылки), которые скрыты не приёмами типа белый текст на белом фоне, а запрятаны при помощи css, анпример display:none и т. п. ? Такой текст (ссылки) вредны для сайта?

linux

01.02.2010

А если сайт продвигается и по геозависимым и по независимым запросам и аудиторией является вся Россия, то самый правильный регион для сайта это «Россия»? или лучше быть без региона? Или это одно и то же?

А если добавиться в ЯК и проставить регионы СПб, Мск, Россия — будет лучше?

Работа в сети

02.02.2010

Спасибо за статейку, как раз искал что-то подобное!

seo2z

03.02.2010

>>а запрятаны при помощи css, анпример display:none и т. п. ? Такой текст (ссылки) вредны для сайта?

Да

>>А если добавиться в ЯК и проставить регионы СПб, Мск, Россия – будет лучше?

Да

Михаил

03.02.2010

А у меня статьи в Google нормально проиндексировались, а в Яндексе повыпадали с ошибкой 403. Это что-то на сайте не так или хост(sweb) виноват.

Оксана

09.02.2010

Да уж, кол-во символов в 4000 попробуй разместить на странице, чтобы ещё и читалось…

Может быть будет статья про методы и приемы размещения большого текста на странице?

Спасибо за порядок, который наступает в моей голове.

Maxim

17.02.2010

А каой программный комплекс можно использовать, что б иметь все «в одном флаконе»?

seo2z

Февраль 17th, 2010

пока никакого. Но у меня в планах соорудить простенький инструмент

seo2z

17.02.2010

>>Может быть будет статья про методы и приемы размещения большого текста на странице?

Вполне вероятно ))

niparuski

18.02.2010

Да, мне тоже интересно про ошибку 403 — тоже хостинг у СпейсВеба…

Оксана

18.02.2010

Хотя, с новыми подкрутками яндекс, который теперь плохо реагирует на большие статьи, эта проблема отпала сама собой. Но, иногда очень полезно знать приемчики для адекватного размещения «портянки» текста.

Aspect

19.02.2010

А какие сервисы наподобие W3C Validator ещё знаете? А то он часто такой бред вываливает!!!

Romario

20.02.2010

Спасибо, очень познавательная статья!

У меня недавно возникла проблема. После АПа выдачи Яндекса резко упал трафик с ПС (с 600-700 хостов до 150-170) и с каждым апом пропадают страницы из индекса.

Возможно ли как-то проверить какие страницы попали под фильтр ПС и могло ли на выдачу повлиять то, что после смена шаблона на сайте где-то в течении недели было 2 незакрытых тега и ?

seo2z

Февраль 20th, 2010

посмотрите в панели вебмастера яндекса. Там есть пункт со страницами в индексе и вне индекса.

Romario

20.02.2010

PS: не закрытые теги били div и b

Romario

20.02.2010

Спасибо посмотрим.

А еще у меня такой вопрос. Если у меня на сайте постоянно обновляются некоторые новости (например антивирусные базы) лучше будет для каждого обновления создавать новую новость, при этом текст самой новости почти не меняется (только дата баз) или же в какой-то одной новости просто менять дату и ссылки на новые базы?

seo2z

Февраль 23rd, 2010

Romario, менять даты в одной новости

Romario

23.02.2010

Спасибо большое, как я ждал этого ответа ….

Кстати, Алексей, поздравляю тебя с праздником и желаю победы в конкурсе.

За статистикой конкурса слежу постоянно и могу с уверенностью сказать, что именно на твоем блоге нашел много познавательного, продолжай в том же духе!!!

seo2z

01.03.2010

спасибо, буду стараться, лишь бы поддерживали только )

Kras

06.03.2010

seo2z спасибо вам отличный постовой. Много что для себя нашел. Сейчас пойду таким способом проверять свой сайт

RIk

09.03.2010

Целый мануал. Спасибо очень много интересного для себя нашел.

jobgomel

09.03.2010

Оптимальной плотностью считаю – до 10 %.

С одним из недавних АПов выявилось, что похоже порог плотности ключевиков снижен.

Я стараюсь не вылезать за 6%

nechto111

11.03.2010

Большое спасибо автору за статью. И где жы Вы раньше то были?)) Тут всё доходчиво написано, что осталось только всё проверить у себя. А я то раньше бедолага мучился со всем этим. Подписался на Ваш блог! Буду следить за Вашими поучительными статьями. Спасибо!

Анфиса

18.03.2010

Здравствуйте Seo2z. 1. Скажите, Адвего Плагиатус при оценке использует систему шинглов? Если да, то какой длинны?

С уважением, Анфиса.

seo2z

09.05.2010

>>Скажите, Адвего Плагиатус при оценке использует систему шинглов? Если да, то какой длинны?

Да, использует шинглы. Если не ошибаюсь 7-8 длина

Анфиса

10.05.2010

Здравствуйте, Алексей.)) Пожалуйста ответьте на вопрос из раздела: «анализ беруемого сайта на продвижение».

1. Если сайт имеет не популярную доменную зону в том регионе, где продвигается, надо ли менять доменную зону?

2. Каким инструментом Вы проверяете ориентировочную стоимость ссылок на продвижение в ТОП? Я понимаю, опыт и т.д. Но я не имею опыта. Проверила цену на продвижение сайта, уже попавшего в ТОП, на Сеопульте. Он показал гораздо более высокую цену, чем ту, что я потратила даже без фильтров, которые Вы обещали. Похоже мой запрос он воспринял, как Г.Н.З., хотя сам же выдал ГЗ.

3. Очень нужна статья «Как брать сайты на продвижение», пожалуйста… С уважением, Анфиса

Анфиса

12.05.2010

Здравствуйте, Алексей. Не приходит e-mail подписка на комментарии. Рыскаю. С уважением, Анфиса

Arhat109

12.07.2010

Спасибо за статью. Правда мало что понял, буду перечитывать ишо раз…

Но вот озадачился: проверка на плагиат выдала 100% совпадение с сайтом poisk.ngs.ru… но там все страницы честно ведут на наш сайт ***... как это понять? Ухудшает ли это индексацию у Яши?

Опять же, страницы, на которые интересны переходы с поисковиков содержат 11 внешних ссылок (6 — наших же, остальное баннеры поисковиков и счетчиков) и до 200 внутренних ссылок… основная выдача идет с внутренней базы данных по фирмам и их прайсам… хорошо это или плохо? Ну и непонятно как можно улучшить… контент-то особо не изменишь — он генерится автоматически, практически весь…

AvtoRulit

12.07.2010

Да действительно важно анализировать сайт.

Решил поделиться, именно в этой статье:

Тут недавно нашел, что проходит акция в ***, вы размещаете их статью на своем блоге, а они прогоняют ваш сайт по каталогам за 8 долларов.

Ну вот например их статья на моем блоге.

Рассказал может просто кого-нить заинтересует.

Виктор

26.07.2010

Спасибо создателю этой статьи, очень помогло, все пункты прошёл, за 3 часа я довёл до ума свой сайт будем ждать апа))

orionXL

19.08.2010

Я не совсем согласен с разделом внутренней оптимизации, да, если текст предназначен для продвижения, но если это просто интересная дизайнерская или иного рода статья, то выбор остается за вебмастером…

Hetirtuwastu /ё

08.12.2010

Извините, пожалуйста! Лучшая Поисковая Система (да, подлизываюсь) =)

Мика

13.02.2011

Ооооочень полезная статья для новичков!Спасибки

Дмитрий Исаенко

24.03.2011

А у гугле можно проверить индикацию страний??

Дмитрий Исаенко

24.03.2011

А у гугле можно проверить индикацию страниц??

Вячеслав

30.03.2011

Пойду проверю свой блог. Спасибо.

PrivateInvestor2000

27.05.2011

Спасибо за полезную информацию.

Хотел бы подраскрутить свой сайт:

***

Но самому не справиться — времени не хватает.

Gugik

23.06.2011

Спасибо, за статью, всё толково разжевано.

Ильшат

20.07.2011

Ололо, я вижу спаам, на сием блоге…а по теме, я предпочитаю анализировать через общеизвестный сервис pr-cy, очень даже неплохо все освещает.

n1se

01.10.2011

Спасибо. Провёл аудит своего сайта, выявил недочёты и исправил. Хорошая подборка сервисов для проверки сайта.

Дмитрий

06.11.2011

Проверил свой блог на индексацию.В Яндексе и ГУГЛе есть,на Рамблере еще не проиндексирован

ClipArtus

16.01.2012

Спасибо! Статья очень помогла. Все по пунктам разложено.

Только вот проблемка: Гугль нормально индексирует страницы, а Яндекс не хочет (((

Вроде все правильно делал.

Владимир

31.01.2012

Спасибо, приобрел для себя много нового. Эта статья вместе со статьей технический аудит не раз уже мне помогла. Как оказалось, косяков на моем сайте гораздо больше, чем я думал. Надеюсь, блог и дальше будет развиваться

Александр

14.02.2012

Добавлю свой комент-

По поводу анализа работы хостера — для проверки самого хостера нужно поставить на проверку несколько своих сайтов сидящих на данном хосте. Тогда будет видно — хостер виноват или сайт не оптимизирован.

Если проверять только один сайт — большая вероятность ошибки.

Я проверил 4 своих сайта — 3 нормально , один в зависоне. Значит это не ошибка хостера , а мои недоработки.

как бы так.

Да, совсем забыл — большое спасибо админу за науку

Эдуард

19.03.2012

Очень полезная статья, особенно помогла информация о robots.txt , Спасибо.

Наталья

03.05.2012

Сколько роботов не проверяла, Яшке что-нибудь, да не нравится

aleks

15.07.2012

Админу большой привет и моя благодарность за его работу .

моя оценка 10 из 10.

bidbi-моня

03.02.2013

Есть что запомнить. Но очень много ссылок на pr-cy. Разве нет других сервисов и программ?

Кирилл

15.04.2013

Здраствуйте у меня возник вопрос по поводу проверки на присутствие в ПС

яндекс выдает страницы ,а гугл и рамблер нет.

Хотя если просто пишешь *** в поисковик он выдает страницы.

я так и не могу понять есть сайт в поисковике или нет.

Заранее спасибо.