Сегодня я расскажу вам историю создания сети Интернет от морковкиного заговенья до наших дней. Вы узнаете про главные этапы развития Глобальной сети и познакомитесь с важными для создания Интернета людьми. Вперёд и с песней!

4 октября 1957 года СССР запустил первый искусственный спутник Земли, в результате чего отставание США стало видно невооружённым взглядом. Запуск первого искусственного спутника и стал причиной подписания президентом США Дуайтом Эйзенхауэром документа о создании в рамках министерства обороны Агентства по перспективным научным проектам и исследованиям — ARPA (Advanced Research Projects Agency) (wiki).

В августе 1962 года Дж. Ликлайдером (J.C.R. Licklider) (wiki) из Массачусетского технологического института (MIT) была опубликована серия заметок, в которой обсуждалась концепция «Галактической сети» (Galactic Network). Автор предвидел создание глобальной сети взаимосвязанных компьютеров, с помощью которой каждый сможет быстро получать доступ к данным и программам, расположенным на любом компьютере. По духу, эта концепция очень близка к современному состоянию Интернета.

В октябре 1962 года Ликлайдер стал первым руководителем этого компьютерного проекта.

Управление Advanced Research Projects Agency (ARPA) сменило название на Defence Advanced Research Projects Agency (DARPA) в 1971 году, затем вернулось к прежнему названию ARPA в 1993 году и, наконец, снова стало именоваться DARPA в 1996 году. В статье используется текущее название — DARPA.

Ликлайдер сумел доказать своим преемникам по работе в DARPA — Ивану Сазерленду (Ivan Sutherland) и Бобу Тейлору (Bob Taylor) — а также исследователю из MIT Лоуренсу Робертсу всю важность этой сетевой концепции.

Создание сети Интернет

Леонард Клейнрок из MIT опубликовал первую статью по теории пакетной коммутации в июле 1961 года, а первую книгу — в 1964 году. Клейнрок убедил Робертса в теоретической обоснованности пакетных коммутаций (в противоположность коммутации соединений), что явилось важным шагом в направлении создания компьютерных сетей. Другим ключевым шагом должна была стать организация реального межкомпьютерного взаимодействия.

Для изучения этого вопроса Робертс совместно с Томасом Меррилом (Thomas Merrill) в 1965 году связал компьютер TX-2, расположенный в Массачусетсе, с ЭВМ Q-32, находившейся в Калифорнии. Связь осуществлялась по низкоскоростной коммутируемой телефонной линии. Таким образом, была создана первая в мире (хотя и маленькая) нелокальная компьютерная сеть.

Результатом этого эксперимента стало понимание того, что компьютеры с разделением времени могут успешно работать вместе, выполняя программы и используя данные на удалённой машине. Стало ясно и то, что телефонная система с коммутацией соединений абсолютно непригодна для построения компьютерной сети. Убеждённость Клейнрока в необходимости пакетной коммутации получила ещё одно подтверждение.

В конце 1966 года Робертс начал работать в DARPA над концепцией компьютерной сети. Вскоре появился план ARPANET, опубликованный в 1967 году (wiki).

На конференции, где Робертс представлял свою статью, был сделан ещё один доклад о концепции пакетной сети. Его авторами были английские учёные Дональд Дэвис (Donald Davies) и Роджер Скентльбьюри (Roger Scantlebury) из Национальной физической лаборатории (NPL). Скентльбьюри рассказал Робертсу о работах, выполнявшихся в NPL, а также о работах Пола Бэрена (Paul Baran) и его коллег из RAND (американская некоммерческая организация, занимающаяся стратегическими исследованиями и разработками, wiki).

В 1964 году группа сотрудников RAND написала статью по сетям с пакетной коммутацией для надёжных голосовых коммуникаций в военных системах. Оказалось, что работы в MIT (1961-1967 гг.), RAND (1962-1965 гг.) и NPL (1964-1967 гг.) велись параллельно и при полном отсутствии информации о деятельности друг друга. Разговор Робертса с сотрудниками NPL привёл к заимствованию слова «пакет» и решению увеличить скорость передачи по каналам проектируемой сети ARPANET с 2,4 Кб/с до 50 Кб/с.

Публикации RAND стали причиной возникновения ложных слухов о том, что проект ARPANET как-то связан с построением сети, способной противостоять ядерным ударам. Создание ARPANET никогда не преследовало такой цели. Только в исследовании RAND по надёжным голосовым коммуникациям, не имевшем прямого отношения к компьютерным сетям, рассматривались условия ядерной войны. Однако в более поздних работах по интернет-тематике действительно делался акцент на устойчивости и живучести ARPANET, включая способность продолжать функционирование после потери значительной части сетевой инфраструктуры.

В августе 1968 года, после того, как Робертс и организации, финансируемые из бюджета DARPA, доработали структуру и спецификацию ARPANET, DARPA выпустило запрос на расценки (Request For Quotation, RFQ), организовав открытый конкурс на разработку одного из ключевых компонентов — коммутатора пакетов, получившего название «Интерфейсный процессор сообщений» (Interface Message Processor, IMP). В декабре 1968 года конкурс выиграла группа во главе с Фрэнком Хартом (Frank Heart) из компании Bolt-Beranek-Newman (BBN). После этого роли распределились следующим образом.

Команда из BBN работала над интерфейсными процессорами сообщений, Боб Кан принимал активное участие в проработке архитектуры ARPANET, Робертс совместно с Ховардом Фрэнком (Howard Frank) и его группой из Network Analysis Corporation проектировали и оптимизировали топологию сети, группа Клейнрока из Калифорнийского университета в Лос-Анджелесе (UCLA) готовила систему измерения характеристик сети. Другими активными участниками проекта были Винт Сёрф (wiki), Стив Крокер (Steve Crocker) и Джон Постел (John Postel). Позднее к ним присоединились Дэвид Крокер (David Crocker), которому суждено было сыграть важную роль в документировании протоколов электронной почты, и Роберт Брейден (Robert Braden), создавший первые реализации протоколов NCP и TCP для мейнфреймов IBM.

Благодаря тому, что Клейнрок был известен как автор теории пакетной коммутации и как специалист по анализу, проектированию и измерениям, его Сетевой измерительный центр в UCLA был выбран в качестве первого узла ARPANET. Тогда же, в сентябре 1969 года, компания BBN установила в Калифорнийском университете первый интерфейсный процессор сообщений и подключила к нему первый компьютер.

Второй узел был образован на базе проекта Дуга Энгельбарта (Doug Engelbart) «Наращивание человеческого интеллекта» в Стэнфордском исследовательском институте (SRI). В SRI организовали Сетевой информационный центр, который возглавила Элизабет Фейнлер (Elizabeth [Jake] Feinler). В функции центра входило поддержание таблиц соответствия между именами и адресами компьютеров, а также обслуживание каталога запросов на комментарии и предложения (Request For Comments, RFC, wiki). Через месяц, когда SRI подключили к ARPANET, из лаборатории Клейнрока было послано первое межкомпьютерное сообщение.

Двумя следующими узлами ARPANET стали Калифорнийский университет в городе Санта-Барбара (UCSB) и Университет штата Юта. В этих университетах развивались проекты по прикладной визуализации. Глен Галлер (Glen Guller) и Бартон Фрайд (Burton Fried) из UCSB исследовали методы отображения математических функций с использованием дисплеев с памятью, позволяющих справиться с проблемой перерисовки изображения по сети. Роберт Тейлор и Иван Сазерленд в Юте исследовали методы рисования по сети трёхмерных сцен. Таким образом, к концу 1969 года четыре компьютера были объединены в первоначальную конфигурацию ARPANET — взошёл первый росток Интернета.

В декабре 1970 года Сетевая рабочая группа (Network Working Group, NWG) под руководством С. Крокера завершила работу над первой версией протокола, получившего название «Протокол управления сетью» (Network Control Protocol, NCP). После того, как в 1971-1972 годах были выполнены работы по реализации NCP на узлах ARPANET, пользователи сети, наконец-то, смогли приступить к разработке приложений. В 1972 году появилось первое «горячее» приложение — электронная почта.

В марте Рэй Томлинсон (Ray Tomlinson) из BBN, движимый необходимостью создания для разработчиков ARPANET простых средств координации, написал базовые программы пересылки и чтения электронных сообщений. Позже Робертс добавил к этим программам возможности выдачи списка сообщений, выборочного чтения, сохранения в файле, пересылки и подготовки ответа. С тех пор, более чем на десять лет, электронная почта стала крупнейшим сетевым приложением.

Дальнейшее развитие Интернета

Первоначальная концепция объединения сетей ARPANET постепенно должна была перерасти в Интернет. Интернет основывается на идее существования множества независимых сетей почти произвольной архитектуры, начиная от ARPANET — пионерской сети с пакетной коммутацией, к которой вскоре должны были присоединиться пакетные спутниковые сети, наземные пакетные радиосети и т. д. Интернет, в современном понимании, воплощает ключевой технический принцип открытости сетевой архитектуры. Идея открытой сетевой архитектуры была впервые высказана Каном в 1972 году, вскоре после того, как он начал работать в DARPA.

Деятельность, которой занимался Кан, первоначально была частью программы разработки пакетных радиосетей, но впоследствии она переросла в полноправный проект под названием «Internetting». Ключевым для работоспособности пакетных радиосистем был надёжный сквозной протокол, способный поддерживать эффективные коммуникации, несмотря на радиопомехи или временное затенение, вызванное особенностями местности или пребыванием в туннеле. Сначала Кан предполагал разработать протокол, специфичный для пакетных радиосетей, поскольку это избавило бы от необходимости иметь дело с множеством различных операционных систем и позволило бы продолжать использовать протокол NCP.

Однако NCP не содержал средств для адресации сетей (и машин), расположенных за IMP-устройством в месте назначения, так что некоторые модификации NCP всё же были необходимы. Для обеспечения сквозной надёжности протокол NCP полагался на ARPANET. Если какие-то пакеты терялись, протокол (и, естественно, поддерживаемые им приложения) должны были остановиться.

В модели NCP отсутствовало сквозное управление ошибками, поскольку ARPANET должна была являться единственной существующей сетью. Причём настолько надёжной, что от компьютеров не требовалось умения реагировать на ошибки. В итоге, Кан решил разработать новую версию протокола, удовлетворяющую требованиям окружения с открытой сетевой архитектурой. Этот протокол позднее будет назван Transmission Control Protocol/Internet Protocol (TCP/IP — протокол управления передачей/межсетевой протокол, wiki). В то время как NCP действовал в духе драйвера устройства, новинка должна была в большей мере напоминать коммуникационный протокол.

Кан начал работать над коммуникационно-ориентированными принципами операционных систем ещё будучи сотрудником BBN. Он зафиксировал некоторые из своих ранних соображений в виде внутреннего меморандума BBN, озаглавленного «Коммуникационные принципы операционных систем» («Communications Principles for Operating Systems»). Кан понял, что для эффективного встраивания любого нового протокола, необходимо изучить детали реализации каждой операционной системы.

В результате, весной 1973 года, после образования проекта «Internetting», Кан пригласил Винта Сёрфа (работавшего в то время в Стэнфорде) для совместной работы над детальной спецификацией протокола. Сёрф активно участвовал в проектировании и реализации NCP, поэтому он уже обладал информацией об интерфейсах с существующими операционными системами. Вооружившись архитектурным подходом Кана к коммуникациям и опытом Сёрфа, полученным во время работы над NCP, коллеги объединились для уточнения деталей того, что впоследствии станет семейством протоколов TCP/IP.

Взаимообогащение дало превосходные результаты и первая документированная версия выработанных спецификаций (впоследствии эта версия была опубликована в виде статьи) была распространена на специальной встрече Международной сетевой рабочей группы (INWG), состоявшейся во время конференции в Университете Суссекса в сентябре 1973 года.

Хотя в то время в Исследовательском центре компании «Ксерокс» в Пало-Альто (Xerox PARC) уже велись работы над сетями Ethernet, массового распространения локальных сетей пока не предвиделось. О персональных компьютерах и рабочих станциях вообще не было речи. Первоначальную модель составляли сети национального уровня, такие как ARPANET. Предполагалось, что подобных сетей будет относительно немного.

В результате, под IP-адрес было отведено 32 бита. Из которых первые 8 битов обозначали сеть, а оставшиеся 24 бита — компьютер в сети. Предположение о том, что в обозримом будущем окажется достаточно 256 сетей, пришлось пересматривать с появлением локальных сетей в конце 1970-х годов.

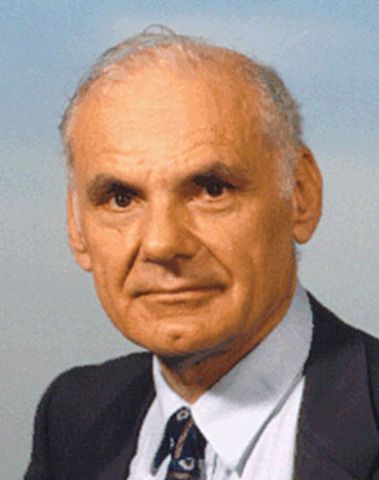

В первоначальном документе Сёрфа и Кана по объединению сетей описывался один протокол, названный TCP. Он предоставлял все услуги по транспортировке и перенаправлению данных в Интернете. Кан планировал, что протокол TCP будет поддерживать целый диапазон транспортных сервисов: от абсолютно надёжной упорядоченной доставки данных (модель виртуального соединения) до датаграммного сервиса, когда приложение напрямую взаимодействует с нижележащим сетевым уровнем, что может привести к случайным потерям, повреждению или дублированию пакетов.

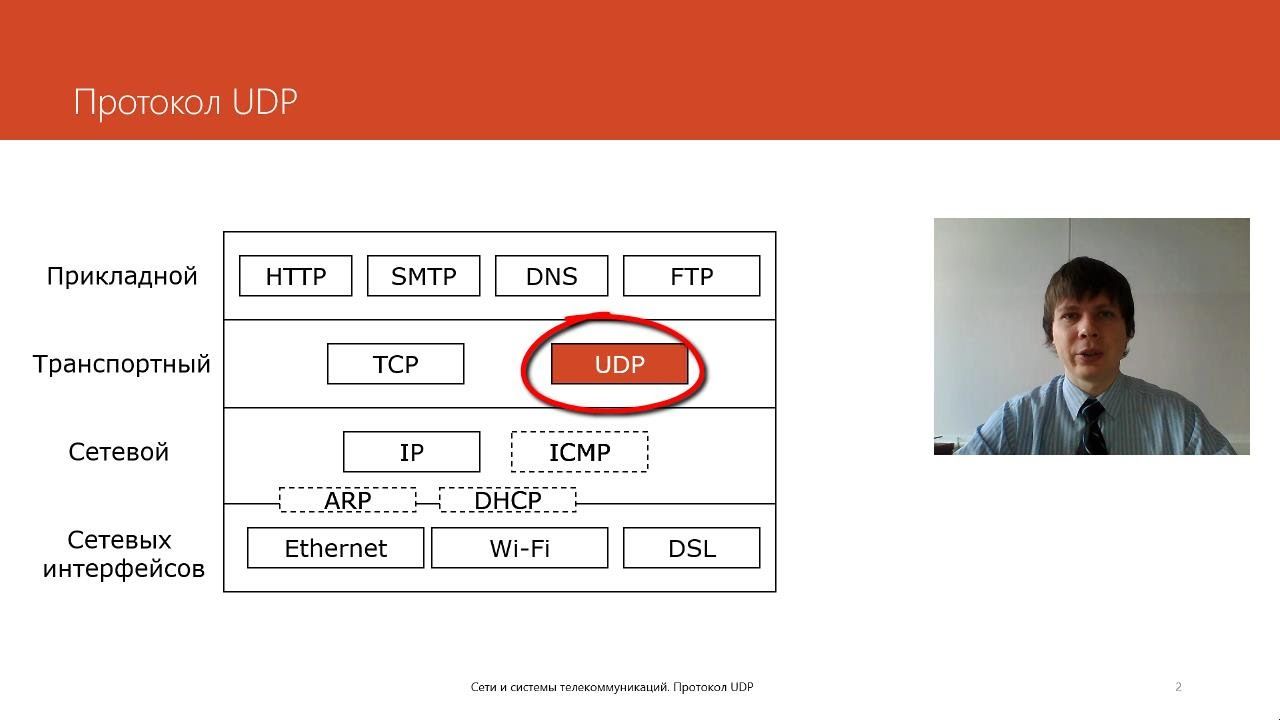

Однако первые попытки реализовать TCP породили версию, поддерживающую только виртуальные соединения. Такая модель отлично работала для приложений типа пересылки файлов или удалённого входа в систему, но ряд ранних исследований продвинутых сетевых приложений (в частности, пакетной передачи голоса, в 1970-е годы) показал, что в некоторых случаях потерю пакетов не следует исправлять на уровне TCP — пусть приложение само разбирается с ними. Это привело к реорганизации первоначального варианта TCP и разделению его на два протокола: простой IP, обслуживающий только адресацию и перенаправление отдельных пакетов, и отдельный TCP, имеющий дело с такими операциями, как управление потоком данных и нейтрализация потери пакетов. Для приложений, не нуждавшихся в услугах TCP, была добавлена альтернатива — пользовательский датаграммный протокол (User Datagram Protocol, UDP, wiki), открывающий прямой доступ к базовым сервисам уровня IP.

Первоначально, основным стимулом к созданию как ARPANET, так и Интернета было совместное использование ресурсов, позволяющее, например, пользователям пакетных радиосетей осуществлять доступ к системам с разделением времени, подключённым к ARPANET. Объединять сети было гораздо практичнее, чем увеличивать число очень дорогих компьютеров. Тем не менее, хотя пересылка файлов и удалённый вход (Telnet) были очень важными приложениями, наибольшее влияние из инноваций того времени оказала, безусловно, электронная почта. Она породила новую модель межперсонального взаимодействия и изменила природу сотрудничества сначала в рамках, собственно, построения Интернета, а позднее — в пределах большей части общества.

На заре Интернета предлагались и другие приложения, включая основанные на пакетах голосовые коммуникации (предшественники интернет-телефонии), различные модели разделения файлов и дисков, а также ранние программы-черви, иллюстрирующие концепцию агентов (и, конечно, вирусов). Ключевая концепция создания Интернета состояла в том, что объединение сетей проектировалось не для какого-то одного приложения, но как универсальная инфраструктура, над которой могут быть надстроены новые приложения. Последующее распространение Всемирной паутины стало превосходной иллюстрацией универсальной природы сервисов, предоставляемых TCP и IP.

После этого начался долгий период экспериментов и разработок, направленных на развитие и шлифовку концепций и технологий Интернета. Отправляясь от первых трёх сетей (ARPANET, Packet Radio, Packet Satellite) и образовавшихся вокруг них коллективов исследователей, экспериментальное окружение росло, вбирая в себя, по существу, все виды сетей и очень широкое сообщество исследователей и разработчиков.

Ранние реализации TCP были выполнены для больших систем с разделением времени (таких, как Tenex и TOPS 20). Когда начали появляться настольные системы, многие посчитали, что для персональных компьютеров TCP — слишком большой и сложный протокол. Дэвид Кларк и его исследовательская группа из MIT решили доказать возможность компактной и простой реализации TCP. Они выполнили её сначала для Xerox Alto (ранняя персональная рабочая станция, созданная в Xerox PARC), а затем для IBM PC.

Эта реализация обладала полной интероперабельностью с другими воплощениями TCP, но была специально настроена на набор приложений и параметры производительности персональных компьютеров. Таким образом удалось продемонстрировать, что рабочие станции могут войти в Интернет наряду с большими системами с разделением времени. В 1976 году Клейнрок опубликовал первую книгу по ARPANET. В ней он обращал особое внимание на сложность протоколов и связанные с этим опасности. Книга способствовала распространению идей пакетной коммутации среди очень широкого сообщества.

Большое распространение в 1980-е годы локальных сетей, персональных компьютеров и рабочих станций дало толчок бурному росту Интернета. Технология Ethernet (wiki), разработанная в 1973 году Бобом Меткалфом (Bob Metcalfe) из Xerox PARC, в наши дни является, вероятно, доминирующей сетевой технологией в Интернете, а ПК и рабочие станции стали доминирующими компьютерами. Переход от небольшого количества сетей с умеренным числом систем с разделением времени (первоначальная модель ARPANET) к множеству сетей привёл к выработке ряда новых концепций и внесению изменений в базовые технологии.

Рост Интернета вызвал важные изменения и в подходе к вопросам управления. Чтобы сделать сеть более дружественной, компьютерам были присвоены имена, делающие ненужным запоминание числовых адресов. Первоначально, при небольшом количестве компьютеров, было разумно иметь единую таблицу с их именами и адресами. Переход к большому числу независимо администрируемых сетей (таких, как ЛВС) сделал идею единой таблицы непригодной. Пол Мокапетрис (Paul Mockapetris) из Института информатики Университета Южной Калифорнии (USC/ISI) придумал доменную систему имён (Domain Name System, DNS, wiki). DNS позволила создать масштабируемый распределённый механизм для отображения иерархических имён компьютеров в интернет-адресах.

С ростом Интернета пришлось пересмотреть и характер функционирования маршрутизаторов.

Первоначально существовал единый распределённый алгоритм маршрутизации, единообразно реализуемый всеми маршрутизаторами в Интернете. В условиях быстрого увеличения числа сетей стало невозможно расширять этот ранний подход в нужном темпе. Его пришлось заменить иерархической моделью маршрутизации с Внутренним шлюзовым протоколом (Interior Gateway Protocol, IGP), используемым внутри каждой области Интернета, и Внешним шлюзовым протоколом (Exterior Gateway Protocol, EGP), применяемым для связывания областей между собой.

Подобная архитектура позволила иметь в разных областях разные варианты IGP, учитывающие специфику требований к стоимости, скорости реконфигурации, устойчивости и масштабируемости. Кроме алгоритма, тяжёлым испытанием стал рост таблиц маршрутизации. Недавно были предложены новые подходы к агрегированию адресов (в частности, бесклассовая междоменная маршрутизация, CIDR), позволяющие уменьшить размер этих таблиц.

Ещё одной проблемой, вызванной ростом Интернета, стало внесение изменений в программное обеспечение, особенно в ПО хостов. DARPA поддержало исследования Университета Беркли (Калифорния) по модификации операционной системы Unix, включая встраивание реализации TCP/IP, выполненной в компании BBN. Хотя позднее в Беркли переписали программы, полученные от BBN, чтобы более эффективно объединить их с unix-системой в целом и ядром ОС в особенности, встраивание TCP/IP в Unix BSD оказалось критически важным для распространения протоколов среди исследовательского сообщества.

Дело в том, что большая часть специалистов в области информатики, в то время, начала использовать Unix BSD в своей повседневной практике. Оглядываясь назад, можно прийти к заключению, что стратегия встраивания протоколов Интернета в операционную систему, поддерживаемую исследовательским сообществом, явилась одним из ключевых элементов успешного и повсеместного распространения Интернета.

Одной из самых интересных задач был перевод ARPANET с протокола NCP на TCP/IP, состоявшийся 1 января 1983 года. Это был переход в стиле «дня X», требующий одновременных изменений на всех компьютерах (на долю опоздавших оставались коммуникации, действовавшие с помощью специализированных средств.) Переход тщательно планировался всеми заинтересованными сторонами в течение нескольких предшествующих лет и прошёл, на удивление, гладко (но привёл к распространению значка «Я пережил переход на TCP/IP»).

Протокол TCP/IP был принят в качестве военного стандарта тремя годами раньше, в 1980 году. Это позволило военным начать использование технологической базы Интернета и, в конце концов, привело к разделению на военное и гражданское интернет-сообщества. К 1983 году ARPANET использовало значительное число военных исследовательских, разрабатывающих и эксплуатирующих организаций. Перевод ARPANET с NCP на TCP/IP позволил разделить эту сеть на MILNET, обслуживавшую оперативные нужды, и ARPANET, использовавшуюся в исследовательских целях.

Таким образом, к 1985 году технологии Интернета поддерживались широкими кругами исследователей и разработчиков. Интернет начали использовать для повседневных компьютерных коммуникаций люди самых разных категорий. Особую популярность завоевала электронная почта, работавшая на разных платформах. Совместимость различных почтовых систем продемонстрировала выгоды массовых электронных коммуникаций между людьми.

2 ноября 1988 года выпускник Корнельского университета Роберт Таппан Моррис запустил в Интернет свою программу, которая из-за ошибки начала бесконтрольное распространение и многократное инфицирование узлов сети. В результате было инфицировано около 6200 машин, что составило 7,3 % общей численности машин в сети. Эта программа, названная «червём Морриса», стала одним из первых вирусов (хотя формально червь не наносил какого-либо ущерба данным в инфицированных ЭВМ). Финансовые убытки, нанесённые «червём Морриса», были оценены в 98 253 260 долларов и мировое сообщество всерьёз озаботилось проблемой компьютерных вирусов.

Параллельно с экспериментальной проверкой интернет-технологий и их интенсивным использованием, частью специалистов по информатике разрабатывались и развивались другие сети и сетевые технологии. Практические достоинства компьютерных сетей и, особенно, электронной почты, продемонстрированные на примере ARPANet, DARPA и организациями, имевшими контракты с министерством обороны США, были замечены специалистами из других кругов и предметных областей. К середине 1970-х годов компьютерные сети начали расти, как грибы после дождя — везде, где для этой цели удавалось найти финансирование.

Министерство энергетики США сначала создало сеть MFENet в интересах исследователей термоядерного синтеза с магнитным удержанием, затем специалисты в области физики высоких энергий получили сеть HEPNet. Для астрофизиков из NASA построили сеть SPAN, а Рик Эдрион (Rick Adrion), Дэвид Фарбер (David Farber) и Лэрри Лэндвебер (Larry Landweber), получив первоначальные субсидии от Национального научного фонда (NSF) США, развернули сеть CSNet, объединившую специалистов по информатике из академических и промышленных кругов.

Свободное распространение компанией AT&T, являвшейся в те далёкие времена монополистом на телефонных коммуникациях, операционной системы UNIX породило сеть USENet — самую большую в мире систему электронных досок объявлений, содержащую сообщения электронной почты и статьи, организованные в группы новостей, объединяя людей по интересам — основанную на встроенном в UNIX коммуникационном протоколе UUCP. В 1981 году Ира Фукс (Ira Fuchs) и Грейдон Фримэн (Greydon Freeman) придумали BITNet — сеть, связавшую академические мейнфреймы сервисами почтовой рассылки.

За исключением BITNet и USENet, ранние сети (в том числе ARPANet) строились целенаправленно. Они должны были использоваться замкнутым сообществом специалистов. Как правило, этим работа сетей и ограничивалась. Особой потребности в совместимости сетей не было. Соответственно, не было и самой совместимости. Кроме того, в коммерческом секторе начали появляться альтернативные технологии, такие как XNS от компании Xerox, DECNet, а также SNA от IBM.

Потребность в обмене электронной почтой привела, тем не менее, к появлению одной из первых интернет-книг — «!%@:: A Directory of Electronic Mail Addressing and Networks» — которую написали Фрей (Frey) и Адамс (Adams). Эта книга посвящена трансляции почтовых адресов и перенаправлению сообщений.

Только в программах JANet (Великобритания, 1984 г.) и NSFNet (США, 1985 г.) было явно провозглашено намерение обслуживать всех причастных к системе высшего образования, независимо от специализации. В самом деле, чтобы американский университет мог получить от NSF средства на подключение к Интернету, он, как было записано в программе NSFNet, «должен обеспечить доступность этого подключения для ВСЕХ подготовленных пользователей в университетском городке».

В 1985 году из Ирландии, для годичного руководства программой NSFNet, был приглашён Дэннис Дженнингс (Dennis Jennings). Он активно способствовал принятию принципиально важного решения об обязательном использовании в NSFNet протокола TCP/IP. Стив Вулф, принявший руководство NSFNet в 1986 году, поставил задачу формирования глобальной сетевой инфраструктуры для обслуживания широких академических и исследовательских кругов. По мнению Вулфа, необходимо было разработать стратегию создания сетевой инфраструктуры, исходя из принципа максимальной независимости от прямого федерального финансирования. Такая стратегия и методы проведения её в жизнь были разработаны и утверждены.

В NSF решили присоединиться к существовавшей под эгидой DARPA иерархической организационной инфраструктуре Интернета, которую возглавлял Совет по развитию Интернета (Internet Activities Board, IAB). Сделанный выбор был закреплён в виде «Требований к интернет-шлюзам» (RFC 985), совместно разработанных специалистами из подведомственных IAB Тематических групп по технологии и архитектуре Интернета (Internet Engineering and Architecture Task Forces) и членами Сетевой технической консультативной группы NSF. Требования обеспечивали совместимость частей Интернета, находящихся в ведении DARPA и NSF. Помимо выбора TCP/IP как основы NSFNet, федеральные агентства США приняли и реализовали ряд дополнительных принципов и правил, сформировавших современный облик Интернета.

Федеральные агентства разделяли между собой расходы на общую инфраструктуру, такую как трансокеанские каналы связи. Кроме того, они совместно поддерживали «администрируемые точки соединения», через которые проходили межведомственные потоки данных. Построенные для обслуживания таких потоков федеральные интернет-станции FIX-E и FIX-W стали прототипом Пунктов доступа к сети и «*IX»-станций — характерных компонентов современной архитектуры Интернета.

Для координации совместной деятельности был образован Федеральный сетевой совет (Federal Networking Council, FNC). Первоначально этот орган назывался Федеральным координационным комитетом по интернет-исследованиям (Federal Research Internet Coordinating Committee, FRICC). Согласно замыслу создателей, FRICC должен был координировать деятельность американских исследователей сетевых технологий в плане участия в международной координации. FNC взаимодействовал также с международными организациями, такими как RARE в Европе, при посредничестве Координационного комитета по межконтинентальным исследовательским сетям (Coordinating Committee on Intercontinental Research Networking, CCIRN). Цель взаимодействия состояла в координации поддержки Интернета мировым исследовательским сообществом.

Разделение расходов между агентствами и координация деятельности в области Интернета имеют давнюю историю. Беспрецедентное соглашение, заключённое в 1981 году Фарбером, действовавшим от имени CSNET и NSF, и Каном, представлявшим DARPA, разрешало потокам данных CSNET использовать инфраструктуру ARPANET на статистической основе, без расчётов «по счётчику». Позднее, действуя в аналогичном ключе, NSF поощрял деятельность региональных (первоначально академических) сетей-компонентов NSFNet по поиску коммерческих, неакадемических клиентов и по расширению спектра услуг для таких клиентов. Повышение эффективности за счёт увеличения масштабов сетевой деятельности следовало использовать для всеобщего снижения платы за пользование Сетью.

NSF разработал и ввёл в действие «Правила пользования» магистральным сегментом NSFNet национального масштаба — NSFNet Backbone. Эти правила запрещали использование магистрали для целей, не способствующих исследовательской и учебной деятельности. Предсказуемым (и запланированным) результатом поощрения коммерческого сетевого трафика на местном и региональном уровнях в сочетании с отказом в транспортировке на национальном уровне стало активное создание и наращивание «частных», конкурирующих «дальнобойных» сетей, таких как PSI, UUNet, ANS CO+RE и (позднее) других.

Процесс увеличения коммерческого использования Сети за счёт частного финансирования детально обсуждался, начиная с 1988 года, в рамках серии конференций «Коммерциализация и приватизация Интернета», проводившихся по инициативе NSF в Правительственной школе Кеннеди в Гарварде. Шло обсуждение и в самой Сети.

В 1988 году в комитете Национального исследовательского совета (National Research Council), который возглавлял Клейнрок, а в число членов входили Кан и Кларк, по поручению NSF был подготовлен доклад, озаглавленный «К вопросу о национальной исследовательской сети». Этот доклад произвёл сильное впечатление на Альберта Гора (Albert Gore, wiki), бывшего в то время сенатором, и дал толчок развитию высокоскоростных сетей, ставших основой будущей информационной супермагистрали.

В 1994 году, вновь под руководством Клейнрока и при участии Кана и Кларка, по поручению NSF был подготовлен ещё один доклад Национального исследовательского совета — «Информационное будущее: Интернет и другие». В этом документе был прорисован проект развития информационной супермагистрали, оказавший долговременное воздействие на трактовку данной проблемы. Авторы доклада обратили внимание на такие важные аспекты, как права на интеллектуальную собственность, этические нормы, ценообразование, обучение, архитектура и законодательство Интернета.

На апрель 1995 года пришлась кульминация приватизационной политики NSF, выразившаяся в прекращении финансирования NSFNet Backbone. Высвободившиеся средства были (на конкурсной основе) перераспределены между региональными сетями для оплаты подключения к ныне многочисленным частным «дальнобойным» сетям, взявшим на себя обеспечение связности Интернета в национальном масштабе. Магистраль NSFNet Backbone прожила восемь с половиной лет. За эти годы на смену исследовательским маршрутизаторам пришло коммерческое оборудование. Сама магистраль выросла с шести узлов, соединённых каналами на 56 Кб/с, до 21 узла с множественными связями на 45 Мб/с. Число сетей в Интернете превысило 50 тысяч. Из них примерно 29 тысяч располагались на территории Соединенных Штатов, а остальные — во всех частях света.

Размах сети NSFNet и размеры финансирования этой программы (200 миллионов долларов за период с 1986 по 1995 гг.) в сочетании с качеством протоколов привели к тому, что к 1990 году, когда окончательно разукомплектовали ARPANET (разукомплектование сети ARPANET было отмечено одновременно с её двадцатой годовщиной на симпозиуме в UCLA в 1989 году.), семейство TCP/IP вытеснило или значительно потеснило во всём мире большинство других протоколов глобальных компьютерных сетей, а IP уверенно становился доминирующим сервисом транспортировки данных в глобальной информационной инфраструктуре.

В 1987 году выявилась потребность в протоколе, обеспечивающем единообразное удалённое администрирование сетевых компонентов (таких, например, как маршрутизаторы). Для этой цели было предложено несколько протоколов. В том числе Простой протокол управления сетью (Simple Network Management Protocol, SNMP, wiki), спроектированный, как подсказывает название, из соображений простоты и ставший развитием более раннего предложения SGMP (Simple Gateway Monitoring Protocol — Простой протокол мониторинга шлюзов).

Кроме SNMP, были предложены протоколы HEMS (High-level Entity Management System — Высокоуровневая система управления объектами — более сложный проект исследовательского сообщества) и CMIP (Common Management Information Protocol — Общий протокол передачи управляющей информации — проект OSI-сообщества). Серия встреч привела к решению вывести HEMS из числа кандидатов на стандартизацию, чтобы разрядить конфликтную ситуацию. Было решено также продолжить работы над обоими оставшимися протоколами — SNMP и CMIP. Причём SNMP рассматривался как краткосрочное решение, а CMIP — как более долгосрочное.

Рынок мог делать выбор по своему усмотрению. В наше время, практически повсеместно, базой сетевого управления служит SNMP.

Спецификация протоколов и координирование

В 1969 году С. Крокер (работавший тогда в UCLA) сделал ключевой шаг, основав серию публикаций «Запросы на комментарии и предложения» (Request For Comments, RFC). Эти статьи должны были служить цели неформального, быстрого распространения идей и их обсуждения с другими сетевыми специалистами. Первоначально RFC-статьи печатались на бумаге и рассылались обычной медленной почтой. После того, как начал использоваться протокол передачи файлов (File Transfer Protocol, FTP, wiki), RFC-статьи стали готовить в виде файлов и передавать посредством FTP.

Сейчас, разумеется, эти документы легко доступны по Всемирной паутине: они лежат на десятках серверов (что такое «сервер») во всех частях света. Стэнфордский исследовательский институт (SRI), выполняя функции Сетевого информационного центра, поддерживал оперативный доступ к каталогам. Джон Постел исполнял обязанности редактора RFC-статей. Он же занимался централизованным распределением номеров версий протоколов. Эти функции Джон выполняет и поныне.

RFC-статьи позволили создать положительную обратную связь, когда идеи и предложения, содержавшиеся в одном документе, служили отправной точкой для создания новых документов с новыми идеями и так далее. Когда достигался определённый уровень согласия (или, по крайней мере, вырабатывался согласованный набор идей), готовились спецификации, служившие основой для реализаций, выполнявшихся несколькими командами исследователей. Со временем, RFC-статьи стали посвящаться, в основном, стандартам протоколов («официальным» спецификациям). Хотя осталась и определённая доля информационных заметок, описывающих альтернативные подходы или идейные основы протокольных и технических решений. Сейчас RFC-статьи рассматриваются как протокол деятельности по стандартизации и реализации Интернета.

Электронная почта сыграла очень важную роль во всех аспектах жизни Интернета. Особенно при разработке спецификаций протоколов, технических стандартов и реализационных решений. Самые первые RFC-статьи зачастую представляли собой набор идей, предлагавшихся на всеобщее обсуждение группой исследователей из какой-то одной местности. Использование электронной почты изменило характер авторства — RFC-статьи стали представляться коллективами авторов с общими взглядами, не зависящими от территориальной принадлежности.

Для выработки спецификаций протоколов в течение долгого времени использовались списки электронной почтовой рассылки (сервисы рассылки). И поныне они остаются важным рабочим инструментом. Сейчас в иерархии IETF насчитывается, ни много ни мало, 75 тематических групп, занимающихся разными аспектами Интернета. Каждая из этих групп имеет список рассылки для обсуждения проектов разрабатываемых документов. После согласования проекта в рабочей группе он публикуется в виде RFC-документа.

Быстрый нынешний рост Интернета во многом объясняется осознанием выгод от распространения информации, которое обеспечивает Сеть. При этом важно понимать, что первым видом информации, распространявшейся в Сети, были RFC-документы, описывавшие проектирование и эксплуатацию Интернета. Этот уникальный метод разработки новых сетевых средств остаётся решающим для дальнейшей эволюции Интернета.

В конце 1970-х годов, когда стало понятно, что рост Интернета сопровождается ростом заинтересованного исследовательского сообщества, всё больше нуждающегося в средствах координации, Винт Сёрф, руководивший в то время в DARPA программой «Интернет», сформировал несколько координирующих органов: Международный совет по сотрудничеству (International Cooperation Board, ICB), Исследовательскую группу «Интернет» (Internet Research Group) и Совет по конфигурационному управлению Интернетом (Internet Configuration Control Board, ICCB). Совет ICCB, который возглавил Петер Кирстен из UCL, должен был координировать работы с рядом европейских стран, участвовавших в проекте Packet Satellite. Исследовательская группа «Интернет» обеспечивала среду для обмена информацией общего характера. Совету ICCB под руководством Кларка отводились «пригласительные» функции: он должен был помогать Сёрфу управлять нарастающей интернет-активностью.

В 1983 году исследовательскую группу «Интернет» возглавил Барри Лейнер. Вместе с Кларком они решили, что продолжающийся рост интернет-сообщества требует перестройки координирующих механизмов. Совет ICCB был упразднён, ему на смену пришла совокупность Тематических групп (Task Forces), занимавшихся определёнными технологическими областями (например, маршрутизаторами, сквозными протоколами и т. п.). Из руководителей Тематических групп был образован Совет по развитию Интернета (Internet Activities Board, IAB). По чистой случайности, Тематические группы возглавили люди, бывшие до этого членами ICCB, а Дэйв Кларк сохранил пост главы совета.

После некоторых изменений в составе IAB Фил Гросс (Phill Gross) стал председателем возрождённой Тематической группы по технологии Интернета (Internet Engineering Task Force, IETF, сайт). В то время, IETF была обычной тематической группой IAB. Как уже отмечалось выше, к 1985 году наблюдался стремительный рост именно практических, технологических аспектов Интернета. Это привело к колоссальному увеличению числа специалистов, присутствовавших на заседаниях IETF. Так что Гросс был вынужден создать в IETF подструктуру в виде рабочих групп.

Рост Интернета сопровождался значительным увеличением числа заинтересованных организаций. Управление DARPA перестало быть крупным единственным инвестором: в дополнение к NSFNet и другим программам, финансировавшимся правительствами США и других стран, начали разворачиваться коммерческие проекты. В том же, 1985 году Кан и Лейнер ушли из DARPA. После чего активность Управления в области Интернета резко пошла на убыль. В результате Совет IAB остался без основного спонсора, но это только укрепило его руководящую роль.

Рост продолжался, приводя к созданию всё новых подструктур в рамках как IAB, так и IETF. В IETF прошло объединение Рабочих групп по областям деятельности с назначением директоров областей, объединившихся в Группу управления технологией Интернета (Internet Engineering Steering Group, IESG). В IAB осознали растущую важность IETF и перестроили процесс стандартизации, сделав IESG основным рецензирующим органом. Изменилась и структура самого Совета IAB. Тематические группы, не входившие в иерархию IETF, были объединены в Тематическую группу интернет-исследований (Internet Research Task Force, IRTF), которую возглавил Постел, и переименованы в Исследовательские группы.

Рост в коммерческом секторе принёс с собой повышенное внимание к самому процессу стандартизации. С начала 1980-х годов и по настоящее время Интернет далеко отошёл от первоначальных исследовательских корней, что выразилось как в расширившемся круге пользователей, так и в возросшей коммерческой активности. Предметом особой заботы стали открытость и честность процесса стандартизации. Это, в сочетании с осознанием необходимости общественной поддержки Интернета, в конце концов, привело к формированию в 1991 году «Сообщества Интернета» (Internet Society) под руководством Сёрфа, работавшего в то время в CNRI, и под патронажем Корпорации национальных исследовательских инициатив (Corporation for National Research Initiatives, CNRI), возглавляемой Каном.

В 1992 году состоялась ещё одна реорганизация: Совет по развитию Интернета (Internet Activities Board) был превращён в Совет по архитектуре Интернета (Internet Architecture Board), функционирующий под покровительством «Сообщества Интернета». Между новым вариантом IAB и IESG были установлены более равноправные отношения, а на IETF и IESG легла большая ответственность за принятие стандартов. В итоге, между IAB, IETF и «Сообществом Интернета» сформировались отношения сотрудничества и взаимной поддержки. Причём целью «Сообщества» стало обеспечение оптимальных условий для работы IETF.

Недавнее создание и широкое распространение Всемирной паутины привлекло в Интернет массу новых людей, никогда не причислявших себя к числу исследователей и разработчиков сетей. Была создана новая координирующая организация — «W3-консорциум» (World Wide Web Consortium, W3C, сайт). Первыми руководителями консорциума стали изобретатель WWW Тим Бёрнерс-Ли (Tim Berners-Lee) и Эл Вецца (Al Vezza). WWW, объединившись с NSFNET и USENET, составили современный Internet (международная сеть).

Новый орган, поддерживаемый Лабораторией информатики MIT, принял на себя обязанности по развитию протоколов и стандартов, ассоциированных с Web. Число хостов в 1992 году превысило 1 000 000. Тогда же программисты (как заработать программисту) из NCSA в университете Иллинойса разработали графический браузер для WWW, который получил название Mosaic (wiki). По согласованию с NCSA, это программное обеспечение распространялось по Интернету бесплатно. Возможность оформления многошрифтового гипертекста, включения цветной графики, звука и видео привело к громадному росту серверов WWW, число которых сейчас растёт по экспоненте.

24 октября 1995 года Федеральный сетевой совет (FNC) единодушно одобрил резолюцию, определяющую термин «Интернет». Это определение разрабатывалось при участии специалистов в области сетей и в области прав на интеллектуальную собственность.

За два десятилетия своего существования сеть Интернет претерпела кардинальные изменения.

Она зарождалась в эпоху разделения времени, но сумела выжить во времена господства персональных компьютеров, одноранговых сетей, систем «клиент-сервер» и сетевых компьютеров.

Она проектировалась до первых локальных вычислительных сетей (ЛВС), но впитала эту новую сетевую технологию, равно как и появившиеся позднее технологии коммутации ячеек и кадров.

Она задумывалась для поддержки широкого спектра функций — от разделения файлов и удалённого входа до разделения ресурсов и совместной работы — породив электронную почту и, в более поздний период — Всемирную паутину.

Но важнее всего то, что Сеть, создававшаяся сначала как объект деятельности небольшого коллектива исследователей, выросла до коммерчески выгодного предприятия, в которое ежегодно вкладываются миллиарды долларов.

Также ты можешь ознакомиться с неофициальной версией истории возникновения Интернета.

Это видео кратко показывает историю создания и развития сети Интернет:

Автор и эскперт: Алексей Востров.

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

Обновление от 2020 года

Хранители ключа от мирового Интернета: кто они и зачем собираются внутри сейфа?

Четыре раза в год два десятка человек встречаются, чтобы провести некую церемонию. Эти собрания не отличались бы от обычных офисных встреч, если бы не беспрецедентные меры безопасности, через которые проходят участники прежде, чем туда попасть: биометрические сканеры, сканеры сетчатки глаза и отпечатков пальцев — это лишь малая часть из них. Причина, по которой они собираются, тоже не самая банальная: некоторые из них являются хранителями уникального ключа от мирового Интернета. А вместе их ключи образуют мастер-ключ, контролирующий одну из главных мер безопасности, лежащую в основе работы Интернета — систему доменных имён (DNS).

Первая церемония встречи «хранителей»:

Что такое DNS?

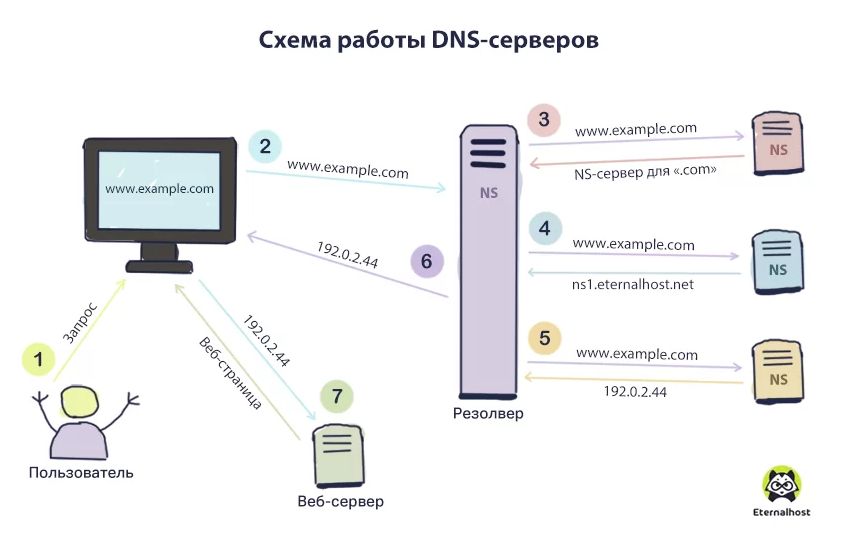

Открыть любой сайт в Интернете можно, введя в строке браузера его числовой IP-адрес или символьное имя (домен). Нам удобнее использовать второй вариант, а машине — первый. Поэтому нужен посредник, который преобразовывал бы символы из доменов в IP-адреса. Для этого и существует система доменных имён — DNS (Domain Name System). Она хранит и управляет информацией о доменных зонах.

Для простоты понимания DNS сравнивают с телефонной книгой, в которой хранятся имена контактов (URL-адреса) и их номера телефонов (IP-адреса). DNS существует не в виртуальном пространстве, а на определённых физических серверах со специальным ПО.

Как работает DNS-сервер?

- Браузер получает запрос от пользователя и направляет его DNS-серверу сети, который ищет совпадение доменного имени и сетевого адреса. Если ответ обнаружен, то страница сайта загружается сразу. В противном случае запрос отправляется серверу более высокого уровня или корневому.

- Корневой сервер направляет запрос серверу первого уровня, который, в свою очередь, передаёт его серверу второго уровня. Это движение продолжается до тех пор, пока не будет найдено совпадение имени и IP-адреса.

- Браузер получает ответ на свой запрос, направляет его к хостингу и страница открывается.

Где находятся DNS-серверы?

Фундаментом для обработки всех запросов о доменных именах являются корневые серверы, отвечающие за корневую DNS-зону. В мире существует 13 корневых серверов. Ими руководят разные операторы, действующие на основании соглашений с корпорацией ICANN. В их числе: университеты, организации Минобороны США и некоммерческие ассоциации. 10 серверов находятся в США, ещё три — в Нидерландах, Швеции и Японии.

Помимо 13 корневых, есть ещё сотни дублирующих корневых серверов, из которых 11 — в России. Все операторы юридически и финансово независимы от ICANN. Поэтому ни одна организация не контролирует всю систему целиком.

Церемония проверки ключей

ICANN создавалась в 1998 году при участии правительства США как организация для регулирования вопросов, связанных с доменными именами и прочими аспектами функционирования Интернета. С 2016 года она стала независимой. Разработанная в компании система с использованием мастер-ключа и его распределённое хранение — часть глобальных мер по обеспечению безопасности Интернета.

С 2010 года держатели ключей встречаются четыре раза в год (дважды на Восточном побережье США и дважды на Западном), чтобы обновить ключи и удостовериться, что Сеть защищена. Хранители ключей — избранная группа экспертов в области безопасности, известные участники комьюнити из разных концов планеты. Их выбрали, исходя из опыта и географического расположения: ни одной стране не позволено контролировать слишком много ключей, чтобы избежать централизации власти в одних руках.

Эти мужчины и женщины контролируют систему, лежащую в основе Сети: систему доменных имён (DNS). Каждый раз, когда хранители встречаются, они проверяют подлинность каждой записи в этих онлайн-адресных книгах. Подмена IP-адресов может привести людей на вредоносные сайты, используемые для взлома компьютеров или кражи данных.

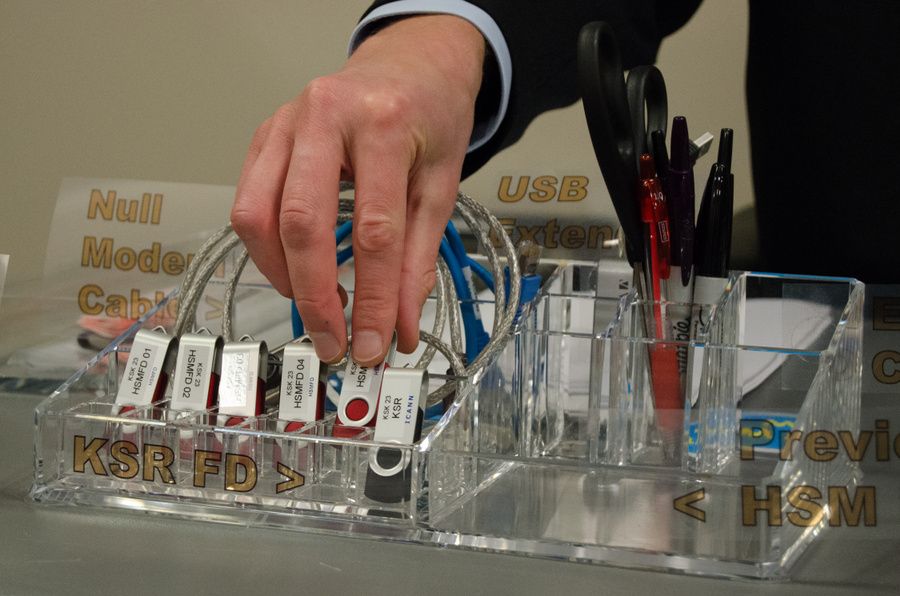

Во время «ритуала» генерируется новый мастер-ключ, который затем активируется с помощью смарт-карт, подписывается хранителями и загружается на USB-носители для серверов различных доменных зон (.ru, .com, .net и т. д.).

На церемониях Восточного и Западного побережья присутствуют по семь держателей ключей. Ещё семь человек по всему миру имеют полномочия по экстренному восстановлению системы, если что-то пойдёт не так. У каждого из 14 держателей первичных ключей (по семь на каждое побережье) есть традиционный металлический ключ от сейфа, в котором хранится смарт-карта, которая, в свою очередь, активирует устройство, создающее новый мастер-ключ.

На случай возникновения чрезвычайной ситуации, «страхующая» семёрка хранит у себя смарт-карты, содержащие фрагмент кода, необходимый для создания нового генератора мастер-ключей. Один раз в год эти семь человек отправляют в ICANN селфи с газетой на текущую дату и их ключом, чтобы подтвердить, что с ними всё в порядке.

Первоначальный процесс отбора хранителей ключей прошёл на удивление малозаметно: компания объявила о наборе участников у себя на сайте и получила всего 40 заявок на 21 позицию. Список участников мероприятия находится в открытом доступе и мало изменился со времён первой церемонии. Россию на ней представляет один из пионеров Рунета Дмитрий Бурков (wiki).

Как проходит церемония?

Церемония Западного побережья проходит в неприметной промзоне в пригороде Лос-Анджелеса, на охраняемой территории. Внутри здания минимум окон (в зале для церемоний их нет вовсе), куча датчиков, сканеров и камер. Даже чтобы попасть в столовую, вам придётся пройти через дверь, требующую пин-кода, смарт-карты и биометрического сканирования руки. Затем вы попадёте в небольшую комнату, в которой одновременно может быть открыта только одна дверь. Затем идёт другая последовательность смарт-карт, отпечатков рук и кодов, чтобы выйти.

В главный зал не допускаются ни охранники, ни уборщицы. Поэтому хранители ключей сами предварительно подготавливают его для мероприятия. Сама церемония — план из более чем 100 пунктов, расписанных с точностью до минуты, каждое отклонение от которого отмечается в официальном протоколе, который все присутствующие позже должны прочитать и подписать.

Доступ внутрь открывается только после сканирования сетчатки глаза уполномоченного сотрудника ICANN. Затем участники процессии попадают в пространство, напоминающее приёмную врача: несколько рядов прикрученных металлических стульев, а напротив — стол. С другой стороны комнаты находится клетка с двумя сейфами повышенной безопасности. Под потолком — камеры, ведущие прямую трансляцию на сайте ICANN.

Один из сотрудников и держатели ключей (для церемонии требуется как минимум трое, а не все семь) входят в безопасную клетку, чтобы забрать свои смарт-карты, хранящиеся в сейфе в специальных пакетах с защитой от вскрытия.

После этого персонал настраивает компьютер, подключает к нему несколько USB-накопителей, один из которых используют в конце церемонии для загрузки подписанного ключа в Интернет: код загрузят на серверы, которые определяют, кто контролирует различные доменные зоны .com, .net, .ru и т. д.

Затем настраивается устройство, которое будет генерировать главный ключ — программно-аппаратный криптографический модуль (HSM). Это простая маленькая серая коробка с клавиатурой и слотом для карт на передней панели. Если её уронить или даже слишком сильного потрясти, она уничтожит хранящиеся внутри ключи. Её активируют смарт-картами, которые хранители только что забрали из сейфа.

Каждый хранитель передаёт свою смарт-карту, устройство активируется, в него вводится несколько строк программного кода, который и генерирует новый цифровой ключ. Затем USB-накопитель передаётся другому сотруднику ICANN: позже он передаст ключ по защищённому каналу и его разместят в Интернете. Он будет действовать три месяца, до следующей церемонии.

После генерации нового ключа хранители снова возвращаются в клетку с сейфами, в которых хранятся их смарт-карты, чтобы вернуть их на место.

Почему церемония проходит в прямом эфире и настолько вычурно?

Тот факт, что базирующаяся в США ICANN (а не правительство или международная организация) выполняет одну из важных задач по поддержанию глобальной интернет-безопасности, часто критикуют. А эта регулярная и, порой, чрезмерная церемония по обновлению ключей призвана показать, насколько серьёзно компания относится к своей миссии, когда речь идёт о поддержании доверия.

В октябре 2016 года у ICANN, всё же, истёк контракт с Министерством торговли США и Национальным управлением информации и связи (NTIA). Поддержкой корневых серверов DNS и реестром доменов верхнего уровня стала заниматься американская компания Verisign, но администрирование адресного пространства осталось за ICANN, которой больше не нужно было согласовывать свои действия с властями США: это немного снизило градус критики.

Для многих стран, в их числе и Россия, отстранение американских властей от «управления Интернетом» было долгожданным событием. Бразилия, Россия и Китай много лет настаивали на передаче контроля над Интернетом какой-нибудь международной организации, например ООН.

Но, тем не менее, большая часть технической инфраструктуры и дата-центров, поддерживающих работу системы, всё ещё находится в США.

Стоит сказать, что сама ICANN категорически против формулировки «ключи от Интернета». Хотя бы потому, что «не существует никаких ключей, благодаря которым работает (или не работает) Интернет». Вся описанная выше процедура связана с ключами, которые касаются только одного из множества компонентов Интернета — механизма проверки подлинности данных в системе доменных имён (DNSSEC). В его основе лежит иерархия криптографических ключей, которая начинается на уровне корневой зоны DNS. Именно за них и отвечает ICANN. Кроме того, криптографический ключ корневой зоны не может быть использован за пределами модуля HSM.

Что будет, если утратить доступ сразу ко всем криптоключам?

Само по себе это маловероятно, потому что ключи хранятся на четырёх модулях HSM в сейфах на территории двух особо охраняемых объектов, расположенных в 4000 км друг от друга (на Восточном и Западном побережье). Но, тем не менее, ICANN хранит ещё и зашифрованные резервные копии для каждого ключа корневой зоны. В случае если выйдут из строя все 4 HSM модуля, компания закажет у производителя новый модуль и восстановит ключи из резервных копий. В этом случае будет проводиться особая церемония в присутствии дополнительных доверенных представителей сообщества и «хранителей частей резервного ключа доступа».

Интернет — это гораздо больше, чем только расширения DNSSEC. Он состоит из множества различных систем и DNS — только одна из них. Управление одним из аспектов работы Интернета, таким как DNS, не означает полного контроля над всеми остальными аспектами.

Автор: Baza.